Уже в течение двух лет в Google наблюдается проблема с индексацией страниц. Новые страницы в некоторых случаях очень сложно попадают в индекс. Первый сбой в индексации зарегистрирован 5 апреля 2019 года во время планового обновления дата-центров.

Что случилось в апреле 2019 года

Индекс Google содержит сотни миллионов страниц. Чтобы показать ответ пользователю за доли секунды, система обращается в ближайший дата-центр. Вот такие центры Google расположены по всему миру:

Чтобы показывать корректный ответ пользователю из любой точки мира, данные во всех центрах должны быть идентичны. Во время очередного обновления данных 5 апреля 2019 года часть индекса была утеряна. Google оперативно отреагировал, принял меры по восстановлению индекса и разработал стратегию предотвращения подобных случаев.

Следующий сбой в индексации Google произошел 22 мая 2019 года, когда системам не хватило памяти для обработки новых URL. Это привело к тому, что часть новых URL система не обработала.

Аналогичный сбой случился и в августе 2019 года.

С тех пор вебмастера и оптимизаторы наблюдают постоянные сложности в индексации как страниц своих проектов, так и страниц со статьями для продвижения.

В индекс сложно входят страницы вне зависимости от таких факторов:

- возраст и авторитетность сайта;

- масштаб — плохо индексируются страницы как больших интернет-магазинов, так и небольших информационных сайтов;

- качество контента — проблемы испытывают и сайты, которые пишут оригинальный, полезный и качественный контент;

- краулинговый бюджет;

- дублированный контент.

Это “боль” оптимизаторов и вебмастеров, для решения которой нет единого на 100% эффективного метода.

Поэтому мы приняли решение помогать всеми силами вебмастерам и оптимизаторам добавлять страницы в индекс Google.

Что мы предлагаем

За время проблем с индексацией мы опробовали несколько методов возвращения статей в индекс. Результат на разных контрольных группах варьировался — 40-70% непроиндексированных страниц с разными статусами все таки вошли в индекс.

Мы понимаем, что метод не дает 100% возврата (иначе давно бы нами применялся).

Мы не заявляем что это революционный тайный метод нашей разработки о котором никто не знает и вообще…

Но это лучше, чем ничего не делать.

Поэтому теперь мы будем:

- делать дополнительную выборку статей;

- выбирать те, которые не вошли в индекс Google в течение срока, данного системной на индексацию, или выпавшие из него;

- за свой счет применять меры для помощи в переиндексировании.

Для этого оптимизатору не нужно подавать никаких заявок и делать дополнительных пометок при размещении. Услуга предоставляется по умолчанию и бесплатно.

Мы надеемся, что общими усилиями мы сможем ввести в индекс Google большую часть “не принятых” страниц.

Напомним — закрытие материала от индексации, отсутствие пути с главной являются нарушением системы и приравниваются к пропаже статьи. Речь в новости идет именно о том материале, который вылетел/не попал в индекс из-за нынешней политики поисковика при соблюдении всех правил нашей системы.

Вебмастеру

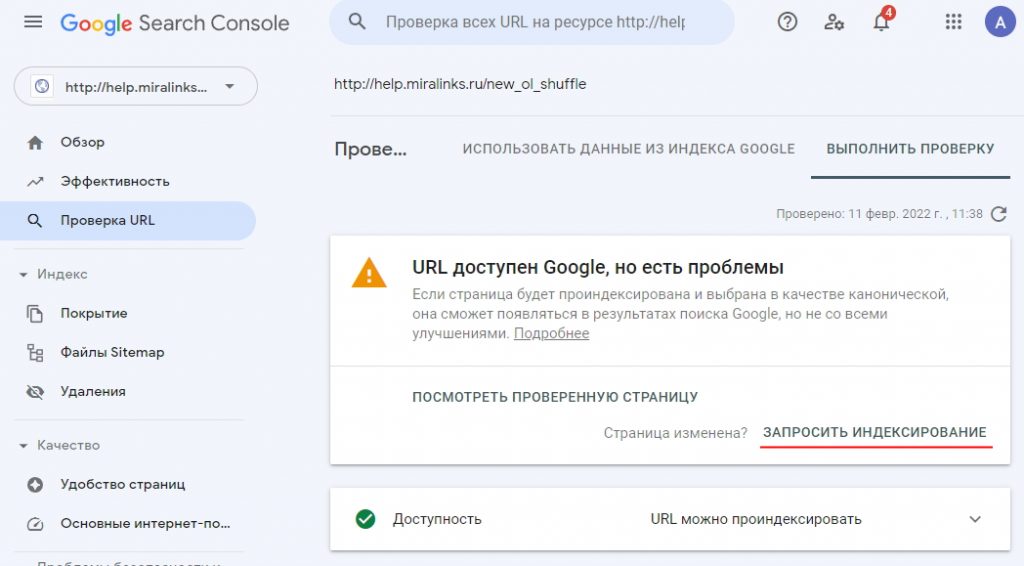

Вебмастерам мы рекомендуем добавлять проблемные статьи на переобход гуглом. Почему-то рекомендуют именно в порядке как на скриншотах.

Пример был взят на скорую руку, проблема, о которой пишет Гугл — мобильная версия хелпа.

Пробовать делать дополнительную перелинкову статьи с другими материалами сайта или проставить дополнительные внешние ссылки.

В случае неиндексации можно переразместить статью по другому адресу, главное не забудьте сменить этот адрес в системе.

В общем, продолжать делать то, что многие делали для этого, а мы будем стараться вместе с вами.

Кейс по Google Indexing API

Друзья, мы добавили в блог кейс, как при помощи индексатора Google удалось вогнать в индекс большую часть страниц интернет-магазина.

Читайте нас в Дзене!

На больших проектах (вроде интернет магазина с десятком тысяч товаров) подобная ситуация может быть не особо заметна. Ну не проиндексировал Google сотню-другую товаров — не существенно. Главное категории каталога в индексе и ранжируются.

А вот с молодыми сайтами — это действительно проблема. Экспериментирую с новым сайтом-статейником. И заметил следующее:

— в индекс могут заходить страницы с полностью скопированным контентом, а статьи с уникальным контентом вне индекса находятся месяцами (то есть уникальность контента отходит на второй план);

— переобход страниц, в большинстве случаев, не дает результата;

— ошибку Google, что сайт неудобен для мобильных устройств можно решить с помощью небольшого увеличения шрифта тега ;

— в индекс быстрее попадают страницы, на которые стоят ссылки с других сайтов;

— раньше (года два назад) для ускорения индексации хорошо помогали соцсети (твиттер, например). Сейчас уже не помогают;

— внутреннюю перелинковку в контентной части лучше делать с тех страниц, которые уже попали в индекс, на те страницы, которых в индексе нет;

— многие вебмастера на форумах пишут, что Яндекс долго индексирует страницы. Сейчас же в сравнении с Google Яндекс просто моментально это делает.

Для интернет магазинов прекрасно работают такие способы перелинковка категорий и подкатегорий ссылками для навигации пользователей и внешние ссылки на страницы, находящиеся вне индекса. Пусть даже эти ссылки будут и nofollow

Я вебмастер. На самом деле пока нет 100% эффективного способа, чтобы вернуть статьи обратно в индекс. Что уже пробовал:

1. просто менять URL, делать 301 и переотправлять на индексацию

2. менять заголовки и мета-теги, менять URL, делать 301 и переотправлять на индексацию

3. частично менять текст в статье, заголовки и мета-теги, менять URL, делать 301 и переотправлять на индексацию

4. делать все выше перечисленное в разном порядке + закупать по 3-5 внешних сапа ссылок на размещенные статьи.

Примерно 50% удалось вернуть, остальные статьи упорно не заходят и их количество растет. Бывает, те статьи, что зашли в индекс, спустя какое-то время все равно вылетают.

Пока не особо понял, что именно влияет — будет статья в индексе или нет. Объем символов статьи не особо коррелирует с ее индексацией.

Думаю, что статьи с очевидным рерайтом или просто с низким % уникальности вылетают или не заходят в индекс. При чем как это проверить достоверно — ХЗ, ибо ясное дело, что перед размещением все статьи проходят проверку на уникальность в нескольких сервисах. Но, одно дело сервисы, а другое дело возможности гугла по поиску неуникального контента, тут мы с ним не на равных.

Возможно, что это временное явление. Но, думаю, что вряд ли и гугл настроен серьезно бороться с говноконтентом.

Комменты топика явно не читали) (типа намек) Копипаст без проблем сидит в индексе Гугла и Яши и в индекс входит, потому тут вы мимо думаете. Вот кол-во и оформление влияет, но не прямо так уж сильно, но трафик явно дает охотнее на большие и хорошо оформленные статьи.

Читал. В том числе и ваши комментарии. Про метод Indexing API вы Америку не открыли. Но, это совершенно не помогает в данной ситуации. Те статьи, что у вас залетали через апишку, они спокойно бы попали в индекс с более длительной задержкой через sitemap. Знаю о чем говорю, есть несколько проектов, где используются просто sitemap и Indexing API.

Тем более проблема существует не только у новых добавленных статей, но уже у контента, который оказался в индексе и потом вылетел.

То что заходит копипаст и не вылетает, это лишь говорит о том, что система еще обкатывается и в любой системе могут быть ошибки. Был случай полного вылета трастового проекта из индекса гугла, что лишь подтверждает о несовершенстве системы.

На последних 200 размещенных статьях в миралинксе за месяц, могу сказать следующее: оформление, смысловая нагрузка и прочее — я не заметил здесь закономерности. Вылетают из индекса хорошие статьи, больше 3к знаков, с фотками, таблицами, маркированным списком и прочим. А шлак, который часто присылают оптимизаторы (2к знаков, без разбивки текста на логически блоки, без фото, с ошибками пр.) может хорошо сидеть в индексе.

Странно. Приведу два примера. Один сайт старый с парой десятков тысяч страниц, 3+- года 50-60% страниц в индексе было (одни зашли, другие вышли) и больше этого загнать не мог. Indexing API его +- полностью вогнал и даже те страницы, которые вообще ни как не хотели лезть. Другой сайт новый и его Гугл кроме главной совсем игнорил, месяц+ ждал. Потом Indexing API его вогнал весь, но не с первых попыток многие входили. Попробуйте создать новую компанию, был тоже опыт, что переставали входить в индекс после Indexing API, создал новую компанию и пошел процесс сразу же. При том и в старом потом тоже стал индексить. Всё не идеально, везде глюки, но надо подстраиваться. Просто сейчас Indexing API, лично у меня, единственно рабочий, пусть частенько и с пробуксовкой, вариант.

Тенденцию с неиндексацией материалов заметили с середины 2020 года. Потом вроде бы все утихло и тут опять )

Некоторые важные материалы даже отправляли на переобход. Результат — 70% индексации.

Цитирую коммент bobyfromuk , мимо которого не смог пройти:

«Дело не сбоях. Была официальная инфа на эту тему от Гугла, вот суть:

Google сокращает частоту сканирования сайтов в целях экономии вычислительных ресурсов. Компания называет это повышением экологичности сканирования и индексирования в рамках ныне модной тенденции сокращения углеродного следа.»

Гугл уже давно тупо «не тянет». А свою несостоятельность объясняет заботой о вымирающих пингвинах и кашалотах. И чем дальше, тем больше его алгоритмы становятся рандомнее, причем это касается не только индексации, но и самого ранжирования страниц. К сожалению, мы оказались по роду деятельности очень зависимы от этого тупеющего электронного монстра, захватившего монопольку над интернетом методами, весьма далекими от рыночных.

Радует только, что проблема замалчивается уже не всеми, и респект Миралинксу, что первым из ссылочных бирж вывел ее на рассмотрение и дал первые рекомендации, в частности по порядку отправки страниц на индексацию.

Кстати, как ВМ никогда не игнорю просьбы рекламодателей по части отправки на повторную индексацию, а теперь попробую еще и в указанном в этой статье порядке.

А что касается статьи, способ принудительной переиндексации стандартный, но к сожалению, гугл в день принимает только 20 ссылок и времени на каждую ссылку тратится прилично.

Было бы здорово Миралинксу запилить какой-нибудь сервис, через который можно было бы групповую отправку ссылок делать на переиндексацию, как в Яндексе.

Как ВМ, всегда отправляю статьи на переиндексацию по просьбе клиентов. Также, стараюсь всех своих постоянных заказчиков-оптимизаторов предупреждать, что требование в задании воткнуть коммерческий анкор или просто ссылку на коммерческий сайт в первых 3-4 абзацах — это совсем не круто, если только у вас не авторитетный информационный ресурс.

Думаю, для поисковиков — это как красная трепка о продажности статьи. )

Также, предупреждаю свох клиентов взаимодействовать со своими статьями, как минимум хотя бы разместить 2-3 осмысленных коммента под ней с нужными ключевиками и при возможности сделать несколько репостов на свои сайты или в соцсети.

Такие простые действия хорошо воспринимаются поисковиками и придают вес и значимость статьи.

Как бы ничего нового, но странно, что мало кто это делает.

Как пример: https://giport.ru/sovet/business-services-tips/finance-tips/kredit-ili-ipoteka-na-pokupku-doma-pod-zalog-nedvizhimosti-usloviya-dlya-samozanyatyh

Хотя, есть и более крутые фишки, которые делают только единицы оптимизаторов, работает очень круто, но разглашать их не буду, извините.

Дело не сбоях. Была официальная инфа на эту тему от Гугла, вот суть:

Google сокращает частоту сканирования сайтов в целях экономии вычислительных ресурсов. Компания называет это повышением экологичности сканирования и индексирования в рамках ныне модной тенденции сокращения углеродного следа. Поскольку сканирование и индексирование являются виртуальными процессами, то они напрямую не влияют на окружающую среду. Однако, вычислительные процессы на компьютерном оборудовании по факту не являются экологичным, поскольку для их работы нужна электрическая энергия добываемая тем или иным способом. Именно так в компании объяснили аборигенам сокращение частоты сканирования интернета.

Эта тема с углеродным следом, набирающая обороты, является величайшей аферой современности! Промывка мозгов. Под этот шум сейчас начинают подкручивать болты практически во всех сферах жизнедеятельности. Мы начинаем платить за воздух, тогда как антропогенный фактор в изменении климата — минимален. Всё больше ученых и специалистов приходят к выводу, что настоящая причина — цикличность в 12 000 лет.

Вопрос действительно очень горячий, у меня уже такой хвост непроиндексированных Гуглом статейных ссылок тянется. Здесь много зависит от ВМ, которые даже не считают необходимых отвечать на письма от Рекламодателя и Администрации, не говоря уже о том, чтобы поставить на переобход. Мне многократно отвечал саппорт о том, что ничего не может поделать с ВМ. А значит возможно назрел вопрос пересмотра Миралинксом некоторых своих правил?

А вот еще такое: меня интересует индекс Гугла, а не Яндекса, но саппорт мне отвечает, что по правилам, если хотя бы в 1 ПС попало в индекс, то норм… На мой взгляд это неправильно.

Спасибо за сообщение!

Именно поэтому мы пытаемся сейчас вогнать в индекс и своими силами. Так как индексация все же это прерогатива Гугла. Для удобства по пунктам

1. Вот ниже откоментили вебмастера которые с нами давно, что это не всегда помогает.

Если бы добавление на переобход 100% давало индексацию, это бы уже было в правилах. А так получается вебмастера накажем, а он все сделал и молчал, просто это не помогло.

Но опять же, это не значит что нужно ничего не делать. Сейчас смотрим как помочь ВМам добавлять быстрее статьи на переобход (если это возможно) так как мы за помощь в таких запросах.

2. Индексация — суть правила больше в запрете на индексацию. Т.е. не в индексе двух ПС означает явные проблемы с сайтом или намеренное скрытие статьи. Это как лакмус.

Если же статья попадает в индекс хотя бы одной из систем и нет явного запрета на другую (мы при обращении это проверяем), и есть перелинковка — то это сложно рассмотреть как нарушение (умышленное препятствие к индексации).

Интересное тут в том, что изначально правило работало под Яндекс, т.е. гугл индексил быстро и все, а его коллега — не спешил. Теперь получается все наоборот в некоторых случаях.

3. Я написал Вам по пулу Ваших статей.

Вы совершили открытие для меня. Оказывается в проектах колонка «Индекс» — это одна из ПС? Если мне важен Google, в колонке «Да», то это может быть «Да в Yandex»?

«отсутствие пути с главной являются нарушением системы»

Аахахаа! Шутка дня.

Поддержу) Давно ли это вообще контролируется?

Все время. Идет постоянная перемодерация каталога, площадки заставляем указать\вернуть или попадают в блок. То же касается кликов до каталога.

Также поддержка сразу реагирует на подобные обращения от пользователей.

В момент принятия площадки в систему это тоже проверяется.

В этом году мы еще более оптимизируем перемодорацию на подобные параметры. Цель — ускорение.

Так как вот мы нашли, написали, вм поправил, а через день убрал, мы это обрабатываем отдельным списком. Презумция невиновности (баг сайтаи прочее) у нас до нескольки попадений.

В новости как раз и «пошутили» для тех кто пытается скрывать — что даже если мы будем заниматься вгоном в индекс, это не значит что нужно нарушать правила.

Ой, да. Очень прошу не путать с визуальным кликами до каталога с главной, когда человек руками докликивает. и URL там немного есть различия

Способ есть и почти 100% вгоняет всё, и новое и старое, и которое годами не индексировалось ещё до нынешних проблем, тоже залетает, пусть и не с первого раза, но второй или третий раз жамкнуть не трудно, дело то того стоит)) Способ очень даже легальный, а предложил его сам Гугл! Много раз писал, по-моему и тут, следить за блогом ПС разных и можно многое почерпнуть для облегчения жизни. Но только владельцы площадок из ГВМ могут это делать. Гуглите и всё будет, способ в паблике гуляет уже и найти не проблема, но настроить там новичкам будет проблемно, но и инструкции в паблике есть и не одна. Способ не озвучу. Вот такая я редиска.

Какой смысл писать о способе, и не дать никакой подсказки?

Даю очевидную подсказку, если уже по ней не найдете, то не знаю… В Гугле вводим — Быстрая индексация страниц через Google, и 2-3 результат будет с инструкцией рабочего метода.

Зачем нужно было тратить время на комментарий без конструктива? Типа выпендриться?

«kiev, Елена»

Наводка дана, подсказка и конструктив в наличии. Способ рабочий есть, кто способ предложил и где озвучено. В Гугле можно легко найти. Хлебных крошек более чем достаточно для поиска. Остальное от вашего желания зависит.

«Елена»

P.S. Хамство это не круто, учитесь общению. Может мне 100 лет в обед и я от вашего хамства сердечный приступ словлю?)

А в чем Вы увидели хамство?

— Типа выпендриться?

Возможно, один из двух сайтов по запросу продвигается. Мы тут все пойдем искать…

Окей, если вам самой совсем не найти, то оглашу способ — Google Indexing API. Инструкции есть и в поиске Гугла и Ютубе.

Это фейк, ибо нет никакого способа… просто Россия не приоритете Гугла 🙂

Да, так оно и есть, верьте в это и живите счастливо)

Для моего сайта такая проблема наблюдалась летом 2021 года. Тогда новые страницы с большим трудом заходили в индекс. Отправка на переобход в консоли вообще не помогала. Через несколько месяцев проблема прошла сама собой. Гугл стал хорошо индексировать новые страницы на моем сайте.

Все верно. Отправка на переобход не панацея((увы. но есть просьбы от рекламодателей — чтобы вебмастер поставил на переобход. Если не поставил — значит не хочет чтобы статья индексировалась. Тем более если погуглить есть чудо кейсы — я поставил и через в день залетело (тут или оно итак бы залетело или повезло).

Поэтому очень просим подобные просьбы рекламодателей не игнорировать)